ついに、RからSearch Consoleを操作できるパッケージが登場しました。Yahoo!もSSL化し検索キーワードの取得が難しくなった今こそ、役に立つのではないでしょうか。ブラウザからSearch Consoleの操作に違和感を感じていた方は、ぜひ利用してみてください。

本パッケージでは検索アナリティクスの取得だけではなく、サイトマップの操作やクロールエラーなどのデータ取得ができます。RとSearch Consoleの連携も「gar_auth」コマンドを実行するだけのお手軽仕様です。

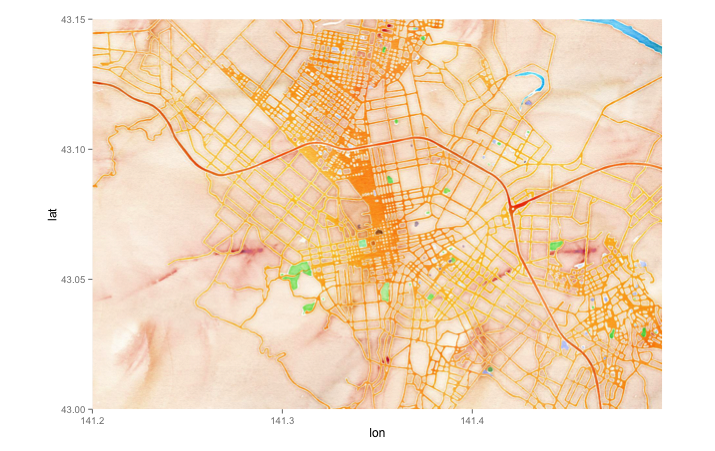

本サイトのデータを取得してみると、Rに関する記事やシャーロットに関するクエリが多いですが、7月に放送が終了した「ダンジョンに出会いを求めているのは間違っているのだろうか」に関するクエリ数が日に日に増えていることがわかりました。2期はやらないのでしょうか。「ダンまち」名作です。

パッケージのバージョンは0.1.2。R version 3.2.1でコマンドを確認しています。

パッケージのインストール

下記コマンドを実行してください。

#パッケージのインストール

#install.packages("googleAuthR")

install.packages("searchConsoleR")実行コマンド

詳細はコマンド、パッケージヘルプを確認してください。

#パッケージの読み込み

library("googleAuthR")

library("searchConsoleR")

#グーグルアカウントの許可

#実行するとウェブブラウザが起動します

gar_auth()

#サーチコンソールで管理しているサイトの取得

sc_websites <- list_websites()

sc_websites

siteUrl permissionLevel

1 https://www.karada-good.net/ siteOwner

#データの取得:search_analyticsコマンド

#取得データの設定:dimensions;"date","country","device","page","query"

#取得データのフィルタ:dimensionFilterExp;

#オプションの種類;"device:DESKTOP or MOBILE or TABLET","page","query"

#演算子の種類;含む:~~,含まない:!~,イコール:==,ノットイコール:!=

#取得データ数の指定:rowLimit;maxは5,000

#フィルタを指定せず検索クエリとページURLを含むデバイス別データを取得

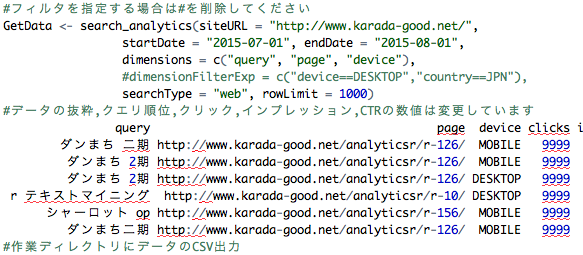

#フィルタを指定する場合は#を削除してください

GetData <- search_analytics(siteURL = "https://www.karada-good.net/",

startDate = "2015-07-01", endDate = "2015-08-01",

dimensions = c("query", "page", "device"),

#dimensionFilterExp = c("device==DESKTOP","country==JPN"),

searchType = "web", rowLimit = 1000)

#データの抜粋,クエリ順位,クリック,インプレッション,CTRの数値は変更しています

query page device clicks impressions ctr position

ダンまち 二期 https://www.karada-good.net/analyticsr/r-126/ MOBILE 9999 99999 1 5.767786

ダンまち 2期 https://www.karada-good.net/analyticsr/r-126/ MOBILE 9999 99999 1 5.284398

ダンまち 2期 https://www.karada-good.net/analyticsr/r-126/ DESKTOP 9999 99999 1 5.376796

r テキストマイニング https://www.karada-good.net/analyticsr/r-10/ DESKTOP 9999 99999 1 3.151659

シャーロット op https://www.karada-good.net/analyticsr/r-156/ MOBILE 9999 99999 1 9.353448

ダンまち二期 https://www.karada-good.net/analyticsr/r-126/ MOBILE 9999 99999 1 5.441573

#作業ディレクトリにデータのCSV出力

#mac用

write.csv(GetData, "GetData.csv", quote = FALSE,

row.names = FALSE, fileEncoding = "CP932", eol = "\r\n")

#windows用

write.csv(GetData, "GetData.csv", quote = FALSE, row.names = FALSE)

#サイトマップの確認:list_sitemapsコマンド

list_sitemaps("https://www.karada-good.net/")

$sitemap

path lastSubmitted isPending isSitemapsIndex lastDownloaded warnings errors

1 https://www.karada-good.net/sitemap.xml 2015-04-13T22:49:34.958Z FALSE TRUE 2015-08-22T23:51:42.784Z 0 0

$contents

type submitted indexed

1 web 356 258

#サイトマップの追加:add_sitemapコマンド

add_sitemap(siteURL = "https://www.karada-good.net/", feedpath = "https://www.karada-good.net/sitemap.xml")

#サイトマップの削除:delete_sitemapコマンド

delete_sitemap(siteURL = "https://www.karada-good.net/", feedpath = "https://www.karada-good.net/sitemap.xml")

#クロールエラーの確認:crawl_errorsコマンド

CErrorsData <- crawl_errors("https://www.karada-good.net/")

head(CErrirsData)

platform category count timecount

1 web notFound 17 2015-05-21

2 web notFound 17 2015-05-22

3 web notFound 18 2015-05-23

4 web notFound 19 2015-05-24

5 web notFound 20 2015-05-25

6 web notFound 20 2015-05-26

#URLエラーの取得:list_crawl_error_samplesコマンド

CErrorsListData <- list_crawl_error_samples("https://www.karada-good.net/")少しでも、あなたのウェブや実験の解析が楽になりますように!!